先週開催されたAlexa Dev Summit Tokyo 2018に参加してきました。オレは今、音声認識技術を活用したシステムの開発案件に従事しています。もっとも、かつようしているのはAmazon Alexaじゃないんですが、同じNLUなんだから、対話設計を行ううえで何かしら参考になるんじゃないかな、と思ったのが参加したきっかけです。

結局のところ2日間のイベント開催期間のうち、数セッションしか聴講できていないのですが、その中で対話設計に関する内容で個人的に印象に残ったものをメモしておきます。逆に言うと、今回話題の中心だったAPL(Alexa Presentation Language)とかサードパーティの開発支援ツールとかは全然メモ取ってません。あしからず。

- VUI実装のポイント

-

-

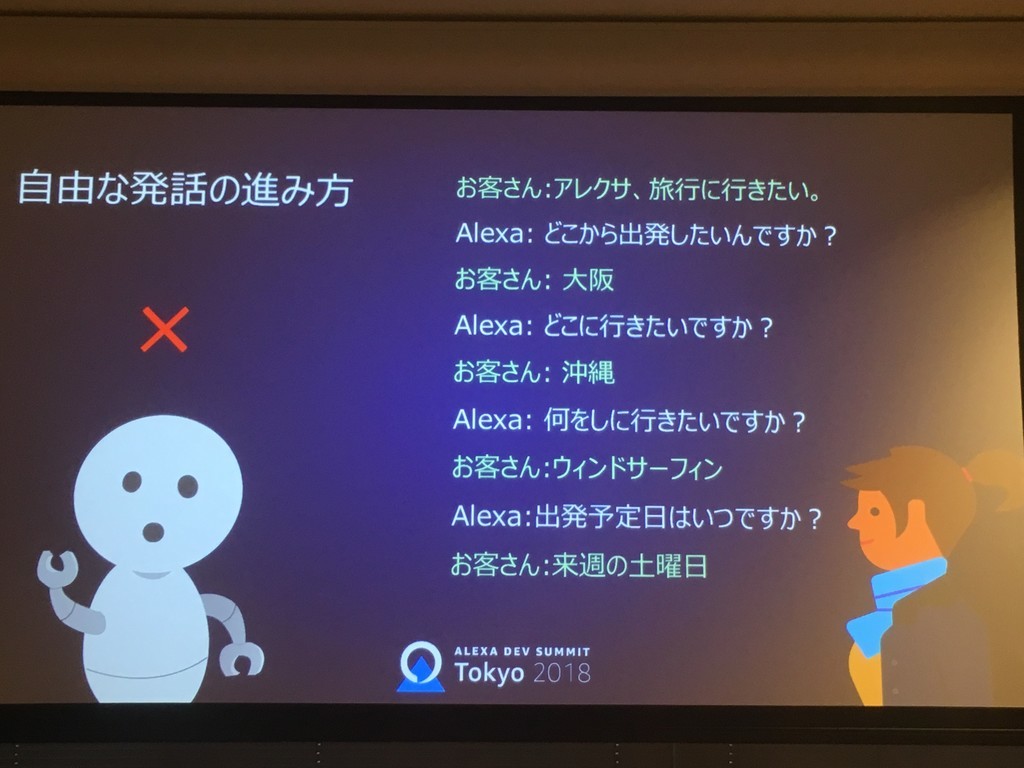

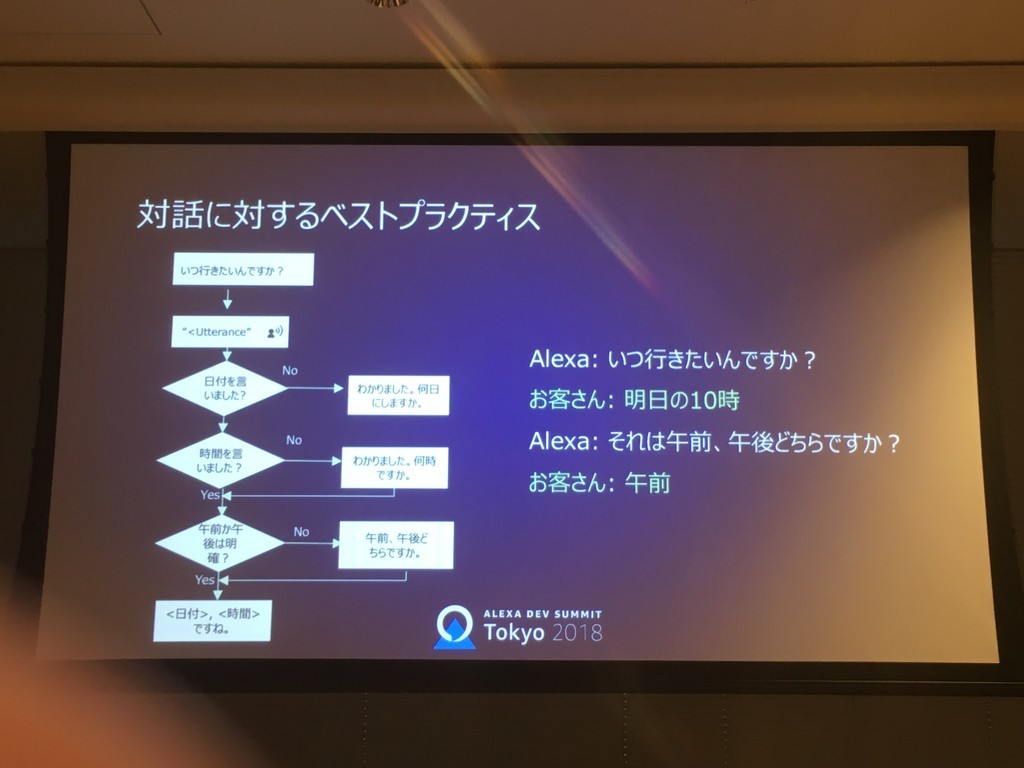

- どの順番でも、一回でも良い

-

-

-

- フローチャートはVUIの設計には向いていない

-

-

-

- ストーリーボードを用いるのが効果的

-

-

- 質問の仕方よるユーザーの方向付けを意識

-

- 対話のステップも最小限に

- マルチモーダル

- GUI

- 目で情報を処理し、手で処理を実行

- VUI(Voice User Interface)

- 耳で情報を処理し、口で処理を実行

- メリット

- 自然

- 早い

- デメリット

- 出来ることと出来ないことがハッキリしない

- 頭の中で情報を処理する必要がある

音声認識って、割と人間と同じように話せて受け答えが出来るところを、みんな目指したり思い描いていたりするんじゃないかと思うんです。以下のイメージ動画なんか、まんまそんな感じですよね。

でも、今回いくつかのセッションを聞く限りでは、少なくともAmazonとAlexaはそれを目指してないし、目指していない理由として、そもそも音声認識・NLUが柔軟で人間らしい対話に不向きな技術要素なんじゃないか、と思えました。また、イメージ動画のような柔軟な会話は、確かにすごいと思うんですけど、実際単なるツールとして人間が使う場合にここまでのものが必要かな?と思えてならないです。介護とか心理療法的なものには有用だし目指すべき価値はあると思うんですが、家電やカーナビ、スマホを操作する程度であれば、もっと端的な命令形で問題無いような気がします。Voice UIで構築するシステムは、人間らしさとかは特に目指すべきではなく、あくまでボタンやスイッチを手でなく声で押すためのもの、であるべきなのかな、と思いました。

Alexa Dev Summit Tokyo 2018の、ちゃんとしたレポートを読みたい人は、クラメソさんの大量のレポートをご参照ください。オレも今から読みます。

Alexa Dev Summit Tokyo 2018 | シリーズ | DevelopersIO